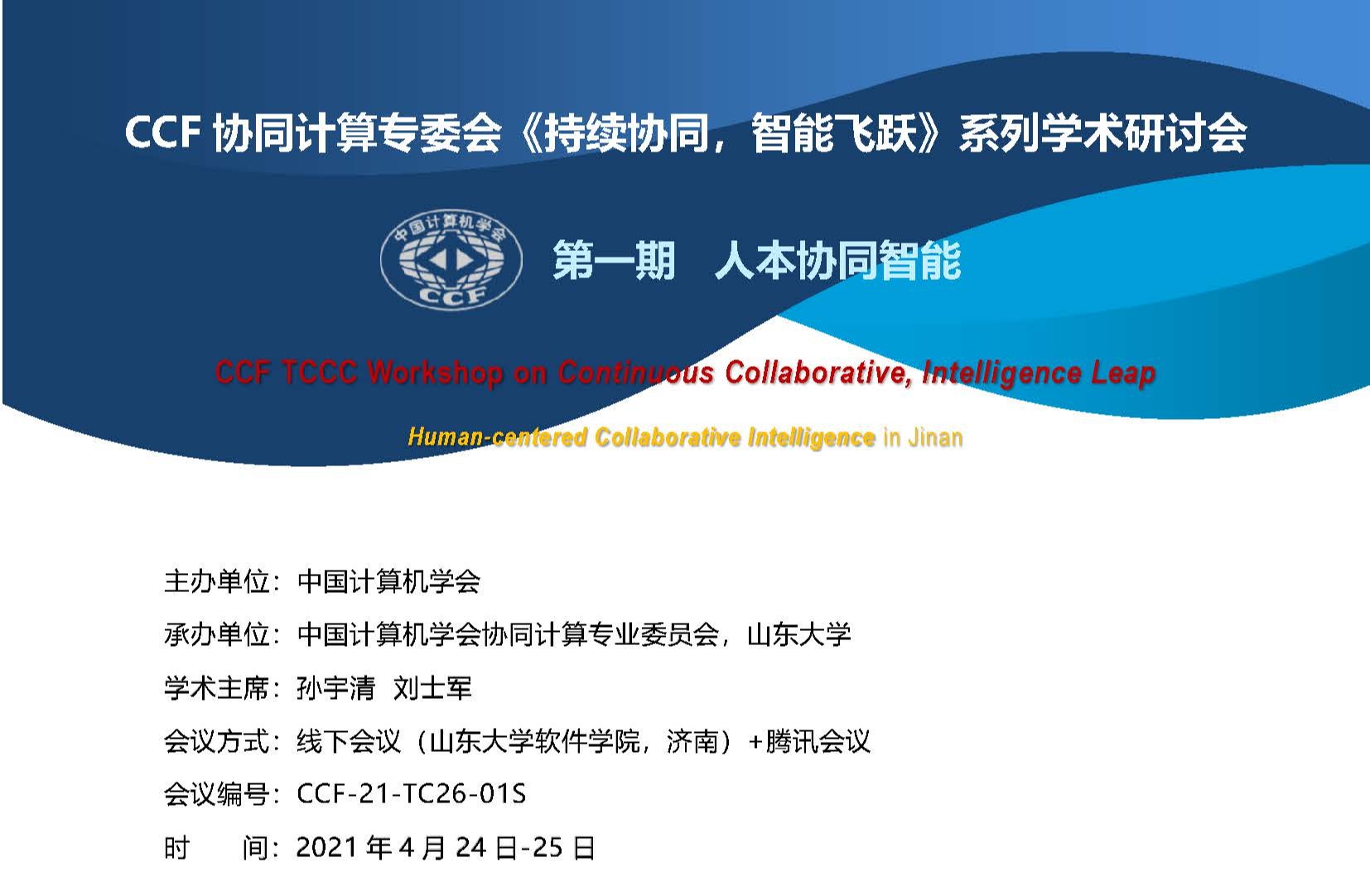

由中国计算机学会主办、中国计算机学会协同计算专业委员会和山东大学软件学院共同承办的CCF 协同计算专委会《持续协同,智能飞跃》系列学术研讨会(CCF TCCC Workshop on Continuous Collaborative, Intelligence Leap)于2021年4月24日-25日在山东大学软件学院召开,以庆祝协同计算专委会成立十周年。活动包括:主题学术报告、前沿技术进展、产学研融合创新研讨等活动,旨在加强协同计算领域的学者交流和学术分享,面向国家和...

在大数据和人工智能背景下,以人为本的管理和决策逐渐进入了专家智能和机器智能交互协同的多元化融合范式,不仅要考虑以数据为中心的客观范式,还要从海量历史数据中学习到可以复用的知识,融入专家范式,融合知识和证据进行分析和推断,从全景视角持续评估和调整,以满足预期目标。

一、 主题:文本生成主讲人:王舰摘要:抽象语义图(Abstract meaning representation,AMR)是文本语义的一种结构化表示,AMR-to-text的生成任务是生成一段反映AMR图语义的自然语言文本。本次讨论班针对上述文本生成任务,讨论三个模型,包括一个基线模型和两类改进,并通过实验结果对比分析。时间和地点:4月17日9:00-10:00(星期六上午9点-10点),软件学院办公楼201会议室 腾讯会议 ID:790 645 118二...

一、 主题:文本改写方法前沿进展主讲人:刘天元摘要:随着对自然语言处理方法的鲁棒性和可解释性的重视,文本改写(Paraphrasing)任务成为一个重要的支撑任务。本周介绍多个前沿的文本改写方法,以了解该任务的前沿进展、存在的问题以及可能的方向。时间和地点:4月10日9:00-10:00(星期六上午9点-10点),软件学院办公楼201会议室二、 主题:基于BERT预训练模型的快速准确多句评分模型主讲人:杨涛摘要:对于成对文本相似性...

一、 主题:2020年顶会最佳论文回顾主讲人:谢翌摘要:在过去的2020年,大量顶会文献中优质论文来自哪些机构?研究热点在哪里?审稿人关注的要素是什么?本次讨论班从2020年顶会的最佳论文出发,探究计算机科学领域已被解决的困难问题、仍然存在的挑战;站在巨人的肩膀上,从优质文献中总结共性,向先进看齐。时间和地点:3月27日13:30-15:00(星期六下午1点30-3点),软件学院办公楼201会议室二、 主题:双向LSTM在全文检索领...